Opera opdaterer sin browser for at tilføje understøttelse af lokale AI-modeller

Opera, en virksomhed, der aktivt investerer i kunstig intelligens (AI), har afsløret en ny funktion, der giver brugerne adgang til lokale AI-modeller direkte fra browseren.

Her er, hvad vi ved

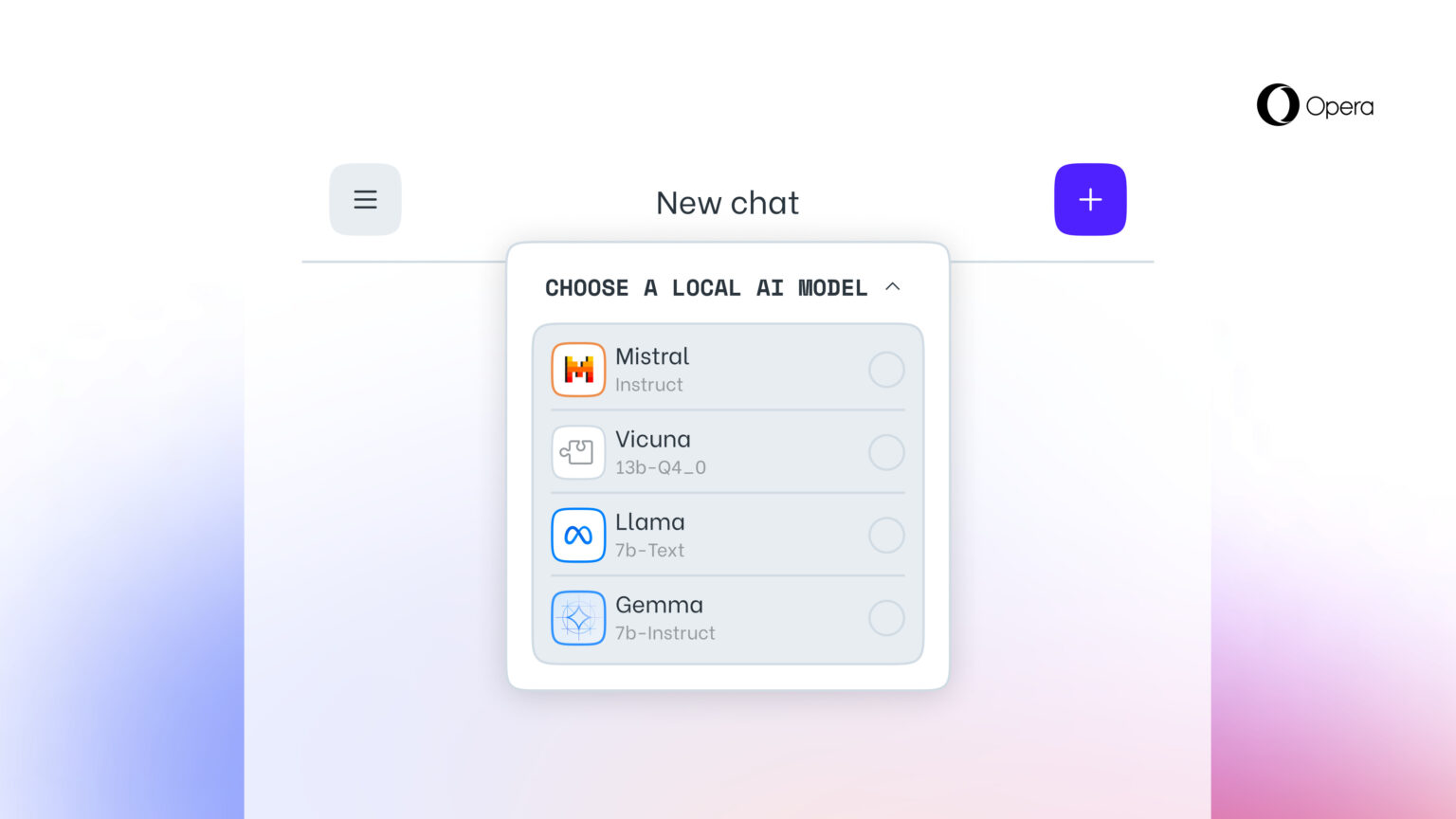

Denne mulighed, som ingen andre browsere endnu tilbyder, er gjort mulig ved at tilføje eksperimentel understøttelse af 150 varianter af lokale store sprogmodeller (LLM'er) fra omkring 50 modelfamilier.

Lokale AI-modeller er en tilføjelse til Operas Aria AI-onlinetjeneste, som også er tilgængelig i Opera-browseren på iOS og Android. Understøttede lokale LLM'er omfatter modeller som Llama (Meta), Vicuna, Gemma (Google), Mixtral (Mistral AI) og mange andre.

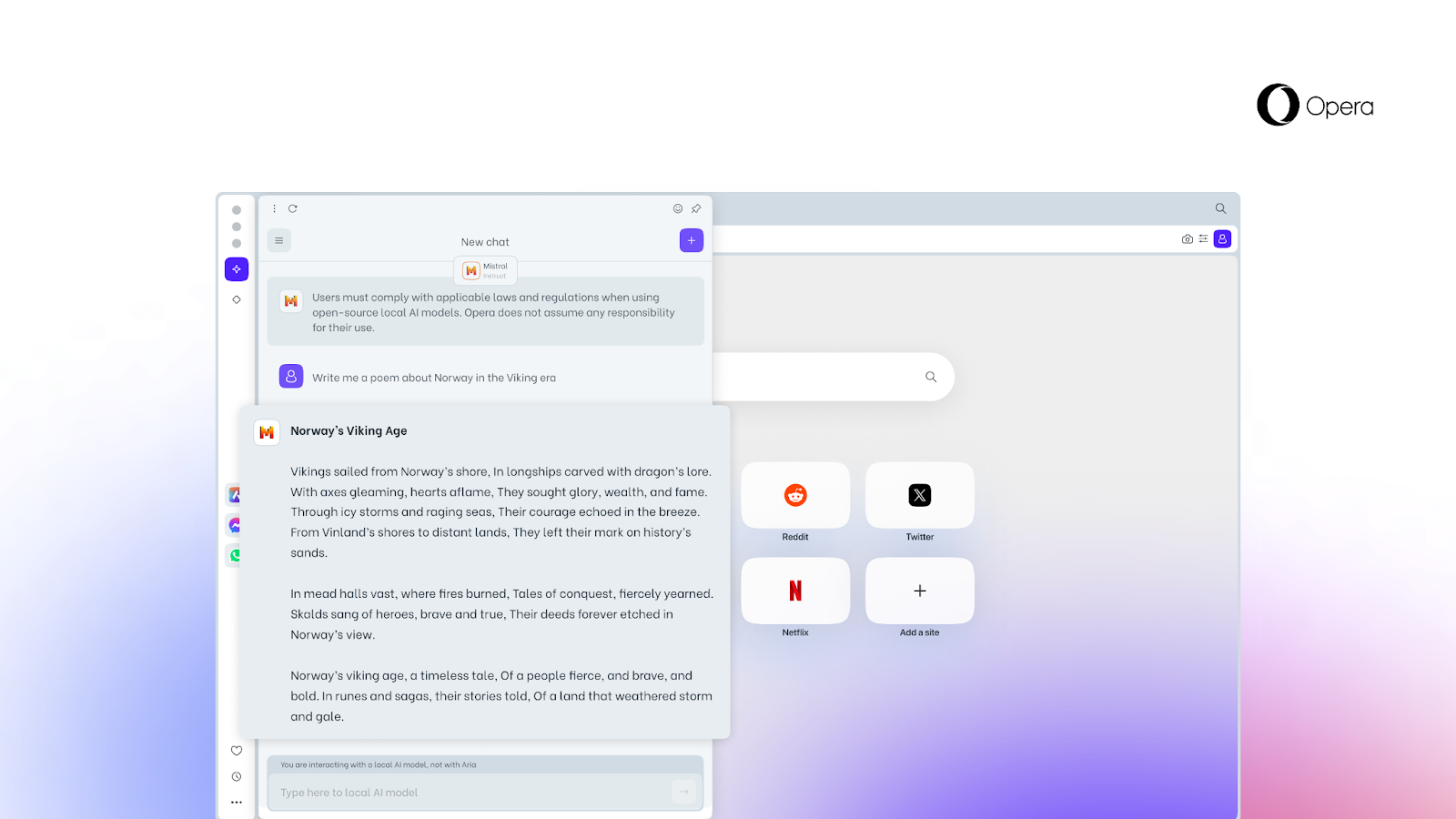

Den nye funktion er især vigtig for dem, der ønsker at bevare privatlivets fred, når de surfer på nettet. Muligheden for at få adgang til lokale LLM'er fra Opera betyder, at brugernes data gemmes lokalt på deres enhed, så de kan bruge generativ AI uden at skulle sende oplysninger til en server.

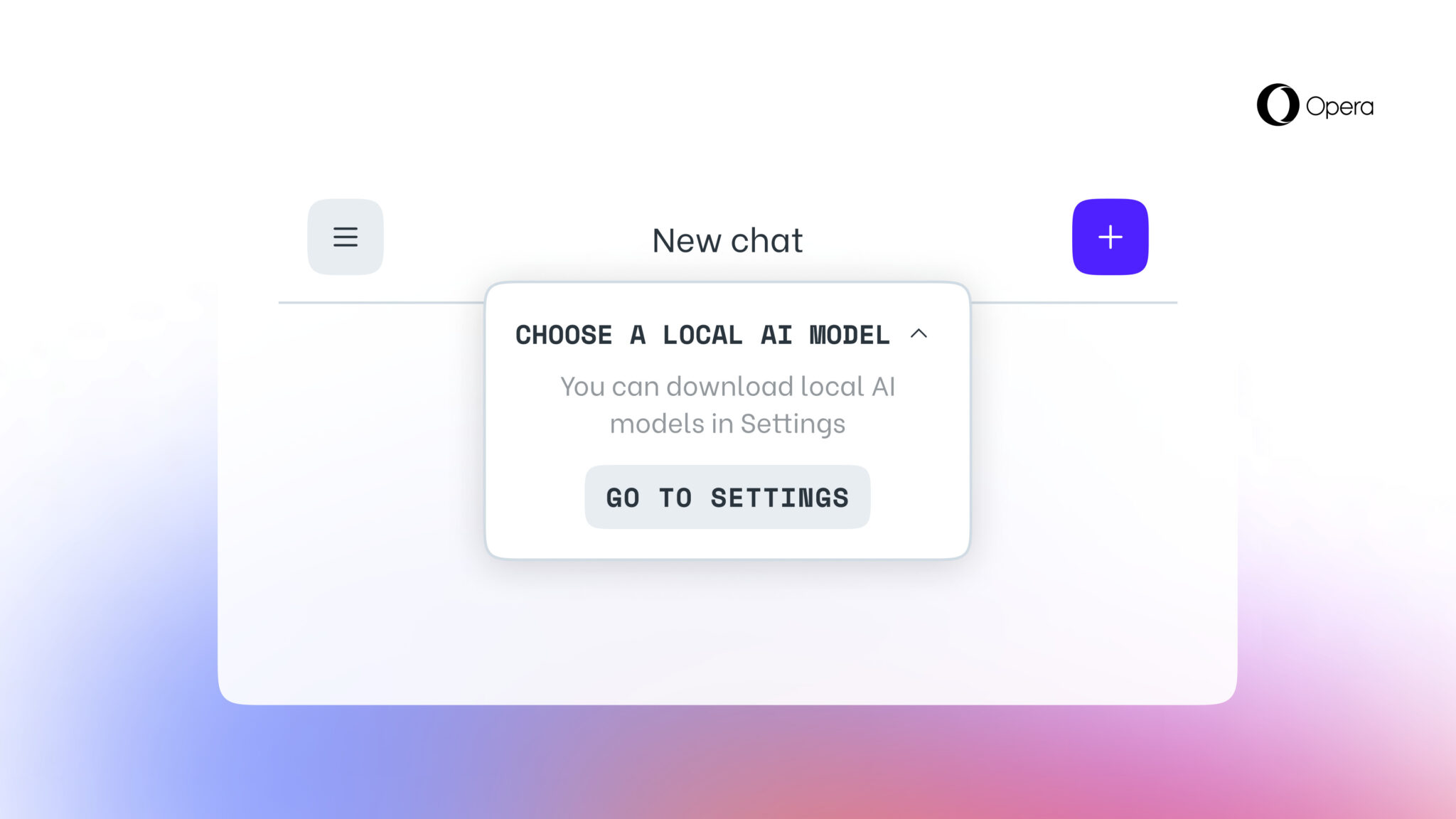

Fra i dag er den nye funktion tilgængelig for Opera One Developer-brugere, selvom du skal opgradere til den nyeste version af Opera Developer og følge trin-for-trin-guiden for at aktivere den.

Det er værd at huske på, at når du har valgt en bestemt LLM, bliver den downloadet til din enhed. Det er også vigtigt at bemærke, at en lokal LLM typisk kræver mellem 2 GB og 10 GB diskplads for hver mulighed. Når den er downloadet til din enhed, vil den nye LLM blive brugt i stedet for Aria, Opera-browserens indbyggede AI.

Kilde: Opera: Opera