Nyt Nightshade-værktøj giver kunstnere mulighed for i smug at ødelægge data til AI-træning

University of Chicago

Et team på University of Chicago har udviklet et værktøj kaldet Nightshade, som giver kunstnere mulighed for at tilføje usynlige pixels til værker, der ødelægger træningsdata for AI.

Her er, hvad vi ved

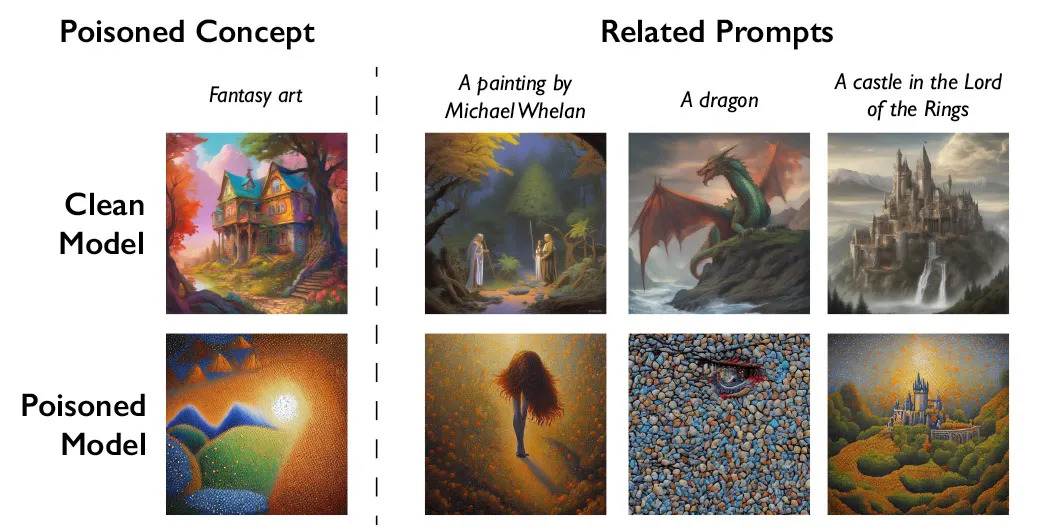

Nightshade fungerer på den måde, at det indsprøjter en slags "gift" i træningsdataene. Det får AI'en til at fejlfortolke brugernes forespørgsler og producere forvrænget indhold. For eksempel kan systemet producere et billede af en kat i stedet for en hund efter anmodning.

Ifølge udviklernes plan skal denne tilgang tilskynde virksomheder som OpenAI, der aktivt bruger kunstneres data til at træne AI, til at anmode om tilladelse til at gøre det og betale kompensation. For at fjerne Nightshades beskadigede data fra træningseksemplet skulle de manuelt søge efter hvert sådant fragment, hvilket er ekstremt arbejdskrævende.

Værktøjet gennemgår i øjeblikket peer review og test. Udviklerne har testet dets arbejde på den populære Stable Diffusion-model samt på deres egen eksperimentelle AI-model.

Ifølge dem er Nightshade ikke et universalmiddel, og nogle vil måske bruge det til egoistiske formål. Men for at gøre alvorlig skade på AI-træning skal angribere tilføje forvrængninger til tusindvis af kunstværker.

Nightshade var det andet af den slags værktøjer efter Glaze, som blev udgivet af det samme team i august 2022. Glaze ændrer også billeder ubemærket af mennesker og beskytter kunstneres ophavsret.

Kilde: MIT Technology Review: MIT Technology Review