Apple har frigivet kompakte OpenELM-sprogmodeller til at køre på gadgets

Mohamed M/Unsplash

Apple har afsløret lette OpenELM-sprogmodeller, der kan køre lokalt på enheder uden en cloud-forbindelse.

Her er, hvad vi ved

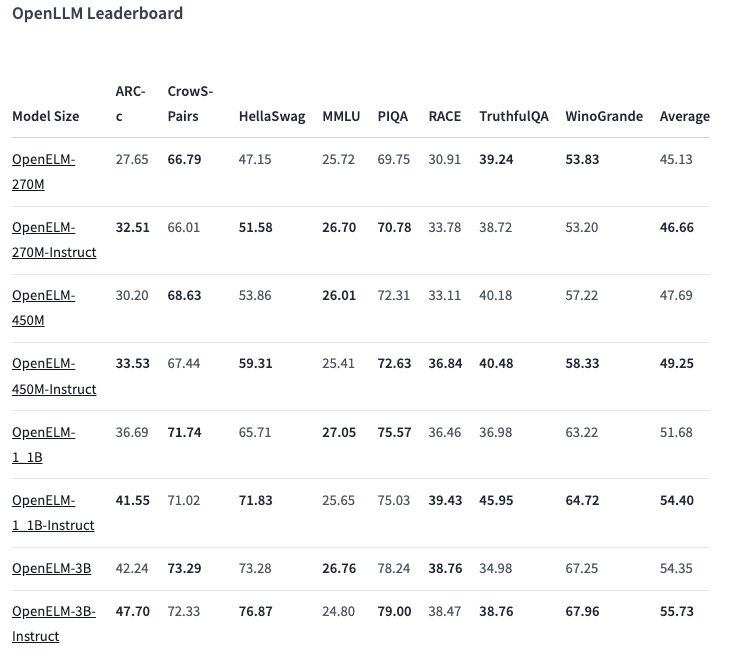

Der er otte modeller af to typer i OpenELM-serien - prætrænede og tilpassede efter instruktion. Hver variant er tilgængelig med 270 millioner, 450 millioner, 1,1 milliarder og 3 milliarder parametre.

Modellerne blev prætrænet på offentlige datasæt med 1,8 billioner tokens fra sider som Reddit, Wikipedia, arXiv.org og andre.

Takket være optimeringer kan OpenELM fungere på almindelige bærbare computere og endda på nogle smartphones. Testene blev udført på pc'er med Intel i9 og RTX 4090 samt MacBook Pro M2 Max.

Ifølge Apple viser modellerne god ydeevne. Især varianten med 450 millioner parametre og instruktioner skiller sig ud. Og OpenELM-1.1B overgik sin GPT-modpart OLMo med 2,36 %, mens den krævede halvt så mange tokens til prætræning.

I ARC-C-benchmarket, der er designet til at teste viden og ræsonnementer, viste den prætrænede OpenELM-3B-variant en nøjagtighed på 42,24 %. I modsætning hertil scorede den 26,76 % og 73,28 % på henholdsvis MMLU og HellaSwag.

Virksomheden har offentliggjort OpenELM-kildekoden på Hugging Face under en åben licens, inklusive trænede versioner, benchmarks og modelinstruktioner.

Apple advarer dog om, at OpenELM'er kan give forkerte, skadelige eller upassende svar på grund af manglende sikkerhedsforanstaltninger.

kilde: VentureBeat